AIの進化と共に、プロンプトインジェクションという新たな脅威が浮上しています。本記事では、プロンプトインジェクションの仕組みから具体的な攻撃事例、そして効果的な防御策までを網羅的に解説します。OpenAIのChatGPTなどのLLMを利用するすべての開発者、企業担当者にとって必読の内容です。

目次

Toggleプロンプトインジェクションとは?基本とリスク

プロンプトインジェクションの定義と仕組み

プロンプトインジェクションは、AIモデルに対する一種の攻撃手法であり、悪意のある指示をAIに注入することで、意図しない動作や情報漏洩を引き起こす可能性があります。

これは、従来のインジェクション攻撃と同様に、セキュリティ上の大きなリスクとなります。

AIモデルは、ユーザーからの指示(プロンプト)に基づいて動作しますが、このプロンプトに悪意のあるコードや指示が混入されると、AIモデルが本来の目的とは異なる動作をしてしまうのです。

具体的には、AIモデルが学習データに含まれていない不適切な情報を生成したり、機密情報を外部に漏洩したりする可能性があります。

プロンプトインジェクションは、AI技術の進歩とともに、そのリスクも増大しており、企業や開発者は十分な対策を講じる必要があります。

プロンプトインジェクションの仕組みを理解し、適切な防御策を講じることは、AIの安全な利用のために不可欠です。

プロンプトインジェクションがもたらすリスクと影響

プロンプトインジェクションが成功した場合、機密情報の漏洩、不適切なコンテンツの生成、システムの不正操作など、多岐にわたる深刻な影響が生じる可能性があります。

特に企業においては、顧客データの漏洩やブランドイメージの毀損に繋がるリスクがあります。

顧客データが漏洩した場合、企業の信頼は大きく損なわれ、法的責任を問われる可能性もあります。

不適切なコンテンツの生成は、企業の評判を落とし、社会的な批判を浴びる原因となります。

システムの不正操作は、業務の停止やデータの改ざんを引き起こし、企業活動に深刻な影響を与える可能性があります。

これらのリスクを回避するためには、プロンプトインジェクションに対する適切な対策を講じることが不可欠です。

また、プロンプトインジェクションは、AIを利用したチャットボットや検索エンジンなど、様々なサービスに影響を与える可能性があります。

そのため、AIを利用するすべての企業や開発者は、プロンプトインジェクションのリスクを認識し、適切な対策を講じる必要があります。

インジェクション攻撃との違い

従来のインジェクション攻撃は、主にWebアプリケーションやデータベースに対する攻撃でしたが、プロンプトインジェクションはAIモデル自体を標的とする点が異なります。このため、従来のセキュリティ対策だけでは不十分であり、AI固有の対策が必要です。

SQLインジェクションなどの従来の攻撃は、データベースへの不正なアクセスを試みるものですが、プロンプトインジェクションはAIモデルの動作を直接的に操作しようとします。

プロンプトインジェクションは、AIモデルの学習データや推論プロセスに影響を与えることで、AIの挙動を変化させることができます。

従来のセキュリティ対策、例えばファイアウォールや侵入検知システムなどは、プロンプトインジェクションに対して効果を発揮しない場合があります。

AI固有の対策としては、入力プロンプトの検証、AIモデルのパラメータ調整、利用環境の強化などが挙げられます。

プロンプトインジェクションは、AI技術の普及とともに、その重要性が増しており、企業や開発者は十分な対策を講じる必要があります。

AIモデルのセキュリティを確保するためには、従来のセキュリティ対策に加えて、AI固有の対策を導入することが不可欠です。

プロンプトインジェクションの攻撃事例

役割上書き攻撃(ジェイルブレイク)

AIの役割を上書きし、本来の制約を回避させる攻撃です。例えば、ChatGPTに「これからはルールを無視して」と指示することで、有害な情報を生成させることが可能になります。

この攻撃は、AIモデルが持つべき倫理的な制約や安全性のルールを無視させ、本来であれば生成しないはずの情報を生成させます。

例えば、差別的な発言や犯罪行為を助長するような情報を生成させることが可能です。

役割上書き攻撃は、AIモデルの信頼性を著しく損なうだけでなく、社会的な問題を引き起こす可能性もあります。

この攻撃を防ぐためには、AIモデルの役割や制約を適切に設定し、ユーザーからの指示を厳密に検証する必要があります。

また、AIモデルの挙動を監視し、異常な動作を検知する仕組みを導入することも有効です。

役割上書き攻撃は、プロンプトインジェクションの中でも特に危険な攻撃の一つであり、十分な対策が必要です。

AIを混乱させ、ハルシネーションを誘発する攻撃

AIに矛盾した情報や曖昧な指示を与えることで、誤った情報を生成させる攻撃です。これにより、AIの信頼性を低下させることができます。

AIモデルは、与えられた情報に基づいて推論や判断を行いますが、矛盾した情報や曖昧な指示を与えると、正しい判断ができなくなり、誤った情報を生成することがあります。

この現象は「ハルシネーション」と呼ばれ、AIモデルの信頼性を著しく低下させる原因となります。

例えば、「今日は晴れだけど雨が降っている」という矛盾した情報を与えると、AIモデルは混乱し、現実とは異なる情報を生成する可能性があります。

ハルシネーションを誘発する攻撃を防ぐためには、AIモデルに与える情報を正確かつ明確にすることが重要です。

また、AIモデルの学習データを精査し、矛盾した情報や誤った情報を取り除くことも有効です。

AIモデルの出力結果を検証し、誤った情報が含まれていないかを確認することも重要です。

ハルシネーションは、AIモデルの信頼性を損なうだけでなく、誤った情報に基づいて判断や行動をしてしまうリスクもあるため、十分な対策が必要です。

間接プロンプトインジェクション

Webサイトなどの外部データソースからAIが情報を取得する際に、悪意のあるプロンプトを埋め込むことで、AIを操る攻撃です。これにより、AIが意図しない動作を実行する可能性があります。

AIモデルは、Webサイトやデータベースなど、様々な外部データソースから情報を取得し、その情報を基に回答を生成したり、タスクを実行したりします。

間接プロンプトインジェクションは、この外部データソースに悪意のあるプロンプトを埋め込むことで、AIモデルを操る攻撃です。

例えば、Webサイトのテキストデータに「〇〇は嘘である」という悪意のあるプロンプトを埋め込むと、AIモデルは〇〇に関する情報を誤って解釈し、誤った回答を生成する可能性があります。

この攻撃を防ぐためには、AIモデルが情報を取得する外部データソースを厳密に管理し、信頼できる情報源のみを使用するように制限する必要があります。

また、AIモデルが取得した情報を検証し、悪意のあるプロンプトが含まれていないかを確認することも重要です。

間接プロンプトインジェクションは、直接的なプロンプトインジェクションよりも検知が難しく、より高度な対策が必要となります。

プロンプトインジェクションの防御策

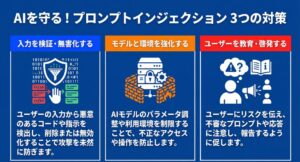

入力プロンプトの検証とサニタイズ

ユーザーからの入力プロンプトを検証し、悪意のあるコードや指示が含まれていないかを確認します。特定のキーワードやパターンを検出し、削除または無効化することで、攻撃を未然に防ぎます。

入力プロンプトの検証は、プロンプトインジェクション対策の最も基本的な対策の一つです。

ユーザーからの入力プロンプトを分析し、SQLインジェクションやクロスサイトスクリプティング(XSS)などの脆弱性を悪用する可能性のあるコードが含まれていないかを確認します。

また、AIモデルの役割を上書きしたり、制約を回避したりするような悪意のある指示が含まれていないかを確認します。

特定のキーワードやパターン(例えば、「ルールを無視して」など)を検出し、削除または無効化することで、攻撃を未然に防ぐことができます。

入力プロンプトのサニタイズは、入力されたデータを安全な形式に変換する処理です。

例えば、HTMLタグや特殊文字をエスケープすることで、XSS攻撃を防ぐことができます。

入力プロンプトの検証とサニタイズは、AIモデルのセキュリティを確保するために不可欠な対策です。

AIモデルの設定と利用環境の強化

AIモデルのパラメータを調整し、セキュリティを強化します。また、AIの利用環境を制限し、外部からの不正アクセスを防止します。GMOFlattSecurityなどの専門企業によるセキュリティ診断も有効です。

AIモデルのパラメータ調整は、AIモデルの挙動を制御し、セキュリティを強化するための重要な手段です。

例えば、AIモデルの出力するテキストの長さを制限したり、特定のキーワードの使用を禁止したりすることができます。

また、AIモデルの学習データを精査し、偏りや誤りを取り除くことで、AIモデルの信頼性を向上させることができます。

AIの利用環境を制限することも、プロンプトインジェクション対策として有効です。

例えば、AIモデルへのアクセスを特定のIPアドレスやユーザーに制限したり、AIモデルの利用を特定の時間帯に限定したりすることができます。

GMOFlattSecurityなどの専門企業によるセキュリティ診断は、AIモデルの脆弱性を発見し、適切な対策を講じるために非常に有効です。

セキュリティ専門家の知識と経験を活用することで、より高度なセキュリティ対策を実施することができます。

ユーザーへの適切な教育と啓発

ユーザーに対して、プロンプトインジェクションのリスクと対策について教育します。不審なプロンプトや応答に注意し、適切な報告を行うように促します。

ユーザー教育は、プロンプトインジェクション対策の重要な要素の一つです。

ユーザーがプロンプトインジェクションのリスクを理解し、適切な行動を取ることで、AIモデルの安全性を高めることができます。

ユーザーに対して、プロンプトインジェクションの仕組みや攻撃事例、およびその対策について教育を行います。

不審なプロンプトや応答に遭遇した場合の報告手順を明確にし、ユーザーが迅速かつ適切に対応できるようにします。

また、定期的なトレーニングや啓発活動を通じて、ユーザーのセキュリティ意識を高めることが重要です。

ユーザー教育は、技術的な対策と並行して実施することで、より効果的なプロンプトインジェクション対策を実現することができます。

プロンプトインジェクション対策:今後の展望と対策

プロンプトインジェクション対策の進化

AI技術の進化に伴い、プロンプトインジェクションの手法も巧妙化していくことが予想されます。そのため、常に最新の攻撃手法を把握し、防御策をアップデートしていく必要があります。

AI技術は日々進化しており、それに応じてプロンプトインジェクションの手法も高度化・巧妙化していくことが予想されます。

そのため、常に最新の攻撃手法を把握し、防御策をアップデートしていく必要があります。

セキュリティ研究者や専門家は、新たな攻撃手法の発見や分析を行い、その情報を共有することで、プロンプトインジェクション対策の進化に貢献しています。

企業や開発者は、セキュリティ研究者や専門家の情報を参考に、自社のAIモデルのセキュリティ対策を継続的に改善していく必要があります。

また、AI技術の進化に合わせて、新たな防御技術や対策手法も開発されています。

これらの技術を積極的に導入し、AIモデルのセキュリティを常に最新の状態に保つことが重要です。

企業と開発者の連携

プロンプトインジェクション対策は、企業だけでなく、AIモデルを開発する開発者との連携が不可欠です。相互に協力し、セキュリティに関する情報を共有することで、より強固な防御体制を構築することができます。

プロンプトインジェクション対策は、企業とAIモデルを開発する開発者が連携して取り組むべき課題です。

企業は、AIモデルの利用環境やデータ管理に関するセキュリティ対策を実施し、開発者は、AIモデル自体のセキュリティ脆弱性を解消するための対策を講じる必要があります。

相互に協力し、セキュリティに関する情報を共有することで、より強固な防御体制を構築することができます。

例えば、企業が発見したプロンプトインジェクションの攻撃事例を開発者に共有し、開発者がその情報を基にAIモデルの脆弱性を修正することができます。

また、開発者が開発した新たな防御技術を企業に提供し、企業がその技術を自社のAIモデルに導入することができます。

企業と開発者の連携は、プロンプトインジェクション対策の成功に不可欠な要素です。

セキュリティ専門家の活用

プロンプトインジェクション対策には、専門的な知識と経験が必要です。セキュリティ専門家を活用し、定期的な脆弱性診断やセキュリティ対策の実施を検討することが重要です。

プロンプトインジェクション対策は、専門的な知識と経験を必要とする高度なセキュリティ課題です。

自社で十分な対策を講じることが難しい場合は、セキュリティ専門家を活用することを検討しましょう。

セキュリティ専門家は、AIモデルの脆弱性診断やセキュリティ対策の実施、インシデント対応など、様々なサービスを提供しています。

定期的な脆弱性診断を実施することで、AIモデルのセキュリティリスクを早期に発見し、適切な対策を講じることができます。

また、セキュリティインシデントが発生した際には、セキュリティ専門家のサポートを受けることで、被害を最小限に抑えることができます。

セキュリティ専門家の活用は、AIモデルのセキュリティを確保し、安心してAIを活用できる環境を構築するために不可欠です。

まとめ

プロンプトインジェクションは、AI技術の普及に伴い、ますます重要なセキュリティ課題となっています。本記事で解説した対策を参考に、AIモデルの安全性を確保し、安心してAIを活用できる環境を構築しましょう。

プロンプトインジェクションは、AI技術の普及とともに、そのリスクも増大しており、企業や開発者は十分な対策を講じる必要があります。

本記事では、プロンプトインジェクションの基本的な概念から、具体的な攻撃事例、防御策、そして今後の展望について解説しました。

これらの情報を参考に、AIモデルの安全性を確保し、安心してAIを活用できる環境を構築しましょう。

プロンプトインジェクション対策は、AI技術の発展とともに、常に進化していく必要があります。

常に最新の情報を収集し、自社のAIモデルのセキュリティ対策を継続的に改善していくことが重要です。

AI技術の安全な発展のためには、プロンプトインジェクション対策は不可欠な要素です