目次

ToggleAIガバナンスとは何か?

AIガバナンスの定義と範囲

AIガバナンスは、人工知能(AI)技術の開発、実装、そして利用全般を対象とした、組織的かつ倫理的な枠組みのことです。この枠組みは、AIが社会に与える影響を適切に管理し、その恩恵を最大限に引き出すことを目的としています。具体的には、AIシステムの開発から運用、廃棄に至るまでのライフサイクル全体を包括し、関係者全員が責任を共有する体制を構築します。

AIガバナンスの範囲は非常に広く、リスク管理、倫理的配慮、透明性の確保、説明責任の明確化、プライバシー保護、セキュリティ対策など、多岐にわたる要素が含まれます。これらの要素は相互に関連し合い、総合的に機能することで、AI技術が社会に調和し、持続可能な形で発展していくことを支えます。AIガバナンスは、単なる技術的な問題解決にとどまらず、社会的な価値観や倫理観を反映した、包括的なアプローチが求められる分野と言えるでしょう。

なぜAIガバナンスが重要なのか

AI技術は、医療、金融、交通、教育など、社会のあらゆる分野に浸透し、私たちの生活を大きく変えようとしています。AIは、業務の効率化、新たなサービスの創出、意思決定の支援など、様々な恩恵をもたらす可能性を秘めています。しかしその一方で、AI技術には、偏ったデータによる差別、プライバシー侵害、セキュリティリスク、誤った情報拡散など、潜在的な危険性も存在します。

AIガバナンスは、これらのリスクを最小限に抑え、AIの恩恵を最大限に享受するために不可欠です。適切なガバナンス体制を構築することで、AI技術が倫理的に利用され、社会の利益に貢献することを保証します。また、AIガバナンスは、AI技術に対する社会的な信頼を高め、その普及を促進する上でも重要な役割を果たします。AIガバナンスの欠如は、社会的な混乱や不信感を生み、AI技術の発展を阻害する可能性があります。したがって、AIガバナンスは、AI技術の健全な発展と社会実装に不可欠な要素であると言えるでしょう。

AIガバナンスの構成要素

AIガバナンスは、単一の要素ではなく、複数の要素が組み合わさって構成される複合的なシステムです。効果的なAIガバナンスを実現するためには、これらの要素を総合的に整備し、連携させることが重要となります。主な構成要素としては、組織体制、プロセス、技術的対策、人材育成などが挙げられます。

組織体制は、AIガバナンスに関する責任と権限を明確化し、関係者間の連携を促進するための基盤となります。プロセスは、AI技術の開発、実装、利用における具体的な手順やルールを定め、リスク管理や倫理的配慮を組み込むためのものです。技術的対策は、AIシステムの安全性、信頼性、公平性を確保するための具体的な技術的な手段を指します。人材育成は、AIガバナンスに関する知識やスキルを持つ人材を育成し、組織全体の能力向上を図るためのものです。これらの要素をバランス良く整備することで、AI技術が社会に貢献し、持続可能な形で発展していくことを支えることができます。

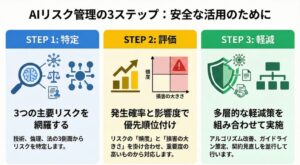

AIリスクの特定と評価

AIリスクの種類と特徴

AI技術の利用には、様々なリスクが伴います。これらのリスクは、技術的な側面、倫理的な側面、法的な側面など、多岐にわたります。技術的なリスクとしては、AIシステムの誤認識や判断ミス、セキュリティ上の脆弱性、データの品質問題などが挙げられます。倫理的なリスクとしては、偏見や差別、プライバシー侵害、透明性の欠如などが挙げられます。法的なリスクとしては、知的財産権侵害、データ保護法違反、製品責任などが挙げられます。

これらのリスクは、それぞれ異なる特徴を持ち、発生する可能性や影響度も異なります。例えば、特定のAIシステムは、特定の種類のデータに対して脆弱性を持つ可能性があります。また、AIシステムの利用目的によっては、倫理的な問題が発生しやすい場合があります。したがって、AIリスクを特定する際には、AIシステムの特性、利用目的、関連する法規制などを考慮し、包括的に評価する必要があります。リスクの種類と特徴を理解することで、適切なリスク軽減策を講じることが可能になります。

リスク評価の方法論

AIリスクを適切に管理するためには、リスク評価が不可欠です。リスク評価とは、特定されたリスクの発生可能性と影響度を評価し、優先順位をつけるプロセスです。リスク評価の方法論は様々ですが、一般的なアプローチとしては、リスクアセスメントと呼ばれる手法が用いられます。

リスクアセスメントでは、まず、AIシステムの開発、実装、利用における潜在的なリスクを洗い出します。次に、各リスクについて、発生する可能性(頻度)と、発生した場合の影響度(損害)を評価します。発生可能性と影響度は、定量的または定性的に評価することができます。例えば、発生可能性は、低い、中程度、高いといった段階で評価することができます。影響度は、軽微、重大、壊滅的といった段階で評価することができます。最後に、発生可能性と影響度の評価結果を組み合わせて、リスクの重要度を決定します。リスクの重要度が高いものから順に対応することで、限られた資源を効果的に活用し、リスクを最小限に抑えることができます。

リスク軽減策の実施

AIリスク評価の結果に基づいて、リスク軽減策を実施することが重要です。リスク軽減策とは、リスクの発生可能性を下げる、またはリスクが発生した場合の影響度を下げるための対策です。リスク軽減策は、技術的な対策、組織的な対策、法的な対策など、多岐にわたります。

技術的な対策としては、データの品質向上、アルゴリズムの改善、セキュリティ対策の強化などが挙げられます。組織的な対策としては、倫理委員会の設置、ガイドラインの策定、従業員への研修などが挙げられます。法的な対策としては、契約の見直し、保険の加入、法的アドバイスの取得などが挙げられます。これらの対策を組み合わせて実施することで、AIリスクを効果的に軽減することができます。リスク軽減策を実施する際には、費用対効果を考慮し、現実的かつ実行可能な対策を選択することが重要です。また、リスク軽減策の効果を定期的に評価し、必要に応じて改善することも重要です。

AI倫理と社会的責任

倫理的AI原則の重要性

AI技術の急速な発展に伴い、倫理的な問題への関心が高まっています。AIは、社会に大きな影響を与える可能性を秘めているため、倫理的な観点から適切に管理する必要があります。倫理的AI原則は、AI技術の開発と利用における基本的な指針となり、AIが社会に与える負の影響を最小限に抑えることを目的としています。代表的な倫理的AI原則としては、公平性、透明性、説明責任、プライバシー保護、安全性などが挙げられます。

公平性とは、AIシステムが差別的な結果を生み出さないようにすることです。透明性とは、AIシステムの動作原理や意思決定プロセスを理解できるようにすることです。説明責任とは、AIシステムの意思決定について責任を負う主体を明確にすることです。プライバシー保護とは、AIシステムが個人情報を適切に保護することです。安全性とは、AIシステムが人々の安全や健康を損なわないようにすることです。これらの原則を遵守することで、AI技術が倫理的に利用され、社会の信頼を得ることができます。

倫理的課題への対応

AI技術の利用においては、プライバシー、差別、バイアスなど、様々な倫理的課題が発生する可能性があります。これらの課題は、AIシステムの設計、データの収集、アルゴリズムの選択など、様々な段階で生じうるため、包括的な対策が必要です。プライバシー侵害のリスクを軽減するためには、個人情報の匿名化、データ最小化、利用目的の明確化などの対策が有効です。差別やバイアスのリスクを軽減するためには、多様なデータセットの利用、アルゴリズムの公平性評価、差別的な結果に対する監視などの対策が有効です。

倫理的な課題に対応するためには、技術的な対策だけでなく、組織文化の醸成も重要です。倫理的な問題に対する意識を高め、議論を促進することで、より責任あるAI技術の利用を促進することができます。また、倫理的な課題に関する専門家やステークホルダーとの連携も重要です。

社会的責任の遂行

企業は、AI技術の利用を通じて、社会に貢献する責任があります。これは、単に法律や規制を遵守するだけでなく、より積極的に社会的な課題の解決に貢献することを意味します。例えば、貧困、飢餓、環境問題、健康問題など、様々な社会的な課題に対して、AI技術を活用した解決策を開発することができます。また、AI技術の恩恵を広く社会に普及させることも、企業の社会的責任の一つです。AI技術に関する教育やトレーニングを提供することで、人々がAI技術を理解し、活用する能力を高めることができます。

企業の社会的責任を遂行するためには、長期的な視点が必要です。短期的な利益だけでなく、長期的な社会的な影響を考慮し、持続可能な形でAI技術を利用することが重要です。また、ステークホルダーとの対話を重視し、社会的なニーズや期待に応えることも重要です。

AIガバナンスの実践

組織体制の構築

AIガバナンスを効果的に実施するためには、組織体制の構築が不可欠です。組織体制とは、AIガバナンスに関する責任と権限を明確化し、関係者間の連携を促進するための枠組みです。まず、AIガバナンスに関する責任者を任命することが重要です。責任者は、AIガバナンスに関する戦略の策定、リスク管理、倫理的配慮などを担当します。

次に、専門チームを設置することが望ましいです。専門チームは、AI技術に関する知識やスキルを持つメンバーで構成され、具体的なAIガバナンス活動を推進します。また、経営層がAIガバナンスの重要性を認識し、積極的に関与することも不可欠です。経営層の関与は、AIガバナンスに対する組織全体のコミットメントを高め、必要な資源を確保する上で重要となります。組織体制を構築する際には、組織の規模や特性に合わせて、柔軟に対応することが重要です。

プロセスとルールの策定

AI技術の開発、実装、利用に関するプロセスとルールを明確に定めることが重要です。プロセスとルールは、AIガバナンスの具体的な行動指針となり、関係者が一貫した行動をとることを支援します。プロセスには、リスク評価、倫理的レビュー、データ管理、セキュリティ対策などを含める必要があります。

リスク評価プロセスでは、AIシステムの開発段階から、潜在的なリスクを特定し、評価します。倫理的レビュープロセスでは、AIシステムの倫理的な問題点を検討し、適切な対策を講じます。データ管理プロセスでは、データの収集、保管、利用に関するルールを定め、個人情報保護やデータ品質の確保を図ります。セキュリティ対策プロセスでは、AIシステムをサイバー攻撃や不正アクセスから保護するための対策を講じます。プロセスとルールを策定する際には、関係者の意見を反映し、現実的かつ実行可能な内容にすることが重要です。

継続的な改善

AIガバナンスは、一度構築すれば終わりではありません。技術の進歩や社会の変化に合わせて、継続的に改善していく必要があります。AI技術は常に進化しており、新たなリスクや倫理的な課題が生まれる可能性があります。また、社会の価値観や期待も変化するため、AIガバナンスもそれらに合わせて適応する必要があります。

定期的な見直しや評価を行い、必要に応じて組織体制、プロセス、ルールなどを修正することが重要です。見直しや評価は、内部監査、外部評価、ステークホルダーからのフィードバックなどを活用して行うことができます。継続的な改善を通じて、AIガバナンスの効果を高め、AI技術が社会に貢献し続けることを保証することができます。

まとめ:AIガバナンスの重要性と今後の展望

AIガバナンスは、AI技術の健全な発展と社会への貢献に不可欠な要素です。AI技術は、私たちの生活を豊かにする可能性を秘めていますが、同時に、倫理的な問題やリスクも抱えています。AIガバナンスの実践を通じて、AIの潜在的なリスクを管理し、倫理的な課題に対応することで、安全で信頼できるAI社会を実現することができます。

今後は、AIガバナンスに関する国際的な標準や規制が整備されることが期待されます。標準や規制は、AI技術の開発者や利用者が守るべき共通のルールを定め、グローバルな規模でAIガバナンスを推進する上で重要な役割を果たします。また、企業は、AIガバナンスに関する取り組みを積極的に推進し、社会的な信頼を獲得することが重要となるでしょう。AIガバナンスは、単なるコンプライアンス活動ではなく、企業の競争力強化にもつながる可能性があります。AIガバナンスを重視する企業は、社会からの信頼を得て、優秀な人材を引きつけ、持続的な成長を遂げることができるでしょう。