AI技術の進化に伴い、その安全性検証は不可欠です。本記事では、AIの品質と安全性を確保するための検証ツールの重要性、選択肢、及び導入事例について解説します。AIの信頼性を高め、潜在的なリスクを最小限に抑えるための情報を提供します。

目次

ToggleAI安全性検証の重要性と現状の課題

AI技術の急速な発展とリスクの増大

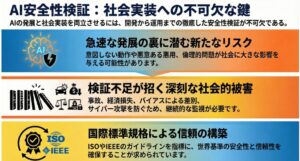

人工知能(AI)技術は、近年、目覚ましい発展を遂げています。産業界における自動化、医療分野での診断支援、金融業界における不正検知など、その応用範囲は多岐にわたり、私たちの生活や社会に大きな変革をもたらしています。しかし、AI技術の急速な発展は、同時に新たなリスクも生み出しています。たとえば、AIが意図しない動作をしたり、悪意のある第三者によって悪用されたりする可能性も否定できません。AIの判断や行動が、倫理的な問題を引き起こすことも考えられます。そのため、AI技術の安全性検証は、その発展と社会実装を両立させる上で、極めて重要な課題となっています。AIが社会に浸透するにつれて、その潜在的なリスクを理解し、適切に対応するための安全性検証の必要性は、ますます高まっています。

安全性検証の遅れによる影響

AIシステムの安全性検証が不十分な場合、様々な問題が発生する可能性があります。例えば、自動運転車の誤作動による事故、金融取引における不正行為の見逃し、医療診断における誤診などが挙げられます。これらの問題は、人命に関わる重大な事故や、経済的な損失、社会的な混乱を引き起こす可能性があります。また、AIシステムの判断や行動にバイアスが含まれている場合、特定のグループに対する差別や不利益が生じる可能性もあります。さらに、AIシステムがサイバー攻撃の対象となった場合、個人情報や機密情報の漏洩、システムの停止など、深刻な被害が発生する可能性があります。これらのリスクを軽減するためには、AIシステムの開発段階から安全性検証を徹底し、運用段階においても継続的な監視と改善を行うことが不可欠です。

国際標準規格と業界の動向

AI安全に関する国際標準規格や業界の動向を把握することは、適切な検証ツールを選ぶ上で非常に重要です。現在、ISO(国際標準化機構)やIEEE(電気電子学会)などの国際機関が、AIシステムの安全性、信頼性、倫理に関する標準規格の開発を進めています。これらの標準規格は、AIシステムの開発者や利用者が、安全なAIシステムを開発、展開、運用するための指針となります。また、業界団体や研究機関も、AI安全に関する様々な取り組みを行っています。例えば、AIの倫理的な問題に関する議論、AIシステムの脆弱性に関する研究、AI安全技術の開発などが行われています。これらの情報を収集し、自社のAIシステム開発や運用に役立てることで、より安全で信頼性の高いAIシステムを実現することができます。最新の動向を常に把握し、適切な対応を行うことが重要です。

AI安全性検証ツールの種類と選び方

品質検証ツール:NRIセキュアのAI品質・適合性検証サービス

NRIセキュアが提供するAI品質・適合性検証サービスは、AIモデルそのものの品質を多角的に評価し、潜在的なリスクを可視化することを目的としています。このサービスでは、AIモデルの精度、ロバスト性、公平性、説明可能性など、様々な品質指標を用いて検証を行います。例えば、精度検証では、AIモデルがどれだけ正確に予測や分類を行えるかを評価します。ロバスト性検証では、AIモデルがノイズや外乱に対してどれだけ頑健であるかを評価します。公平性検証では、AIモデルが特定のグループに対して不当な差別を行っていないかを評価します。説明可能性検証では、AIモデルの判断根拠がどれだけ理解しやすいかを評価します。これらの検証結果に基づき、AIモデルの改善点やリスク軽減策を提案することで、より信頼性の高いAIシステムを実現することができます。

脆弱性テストツール:ユビキタスAIのIoT機器セキュリティ検証サービス

ユビキタスAIコーポレーションのセキュリティ検証サービスは、特にIoT機器などの組み込みシステムにおけるセキュリティリスクの特定に強みを持っています。同社は、ファジングツールbeSTORMや高精度静的解析ツールCodeSonarなどの高度なツールを駆使し、ソフトウェアの脆弱性を徹底的に洗い出します。beSTORMは、様々なプロトコルに対して大量の異常なデータを送り込み、システムの挙動を監視することで、潜在的な脆弱性を発見します。CodeSonarは、ソースコードを静的に解析し、バッファオーバーフロー、メモリリーク、NULLポインタ参照などの潜在的なエラーを検出します。これらのツールを活用することで、開発段階でセキュリティリスクを低減し、安全なIoT機器の開発を支援します。

その他の検証ツール

AIの安全性検証に役立つツールは、上記以外にも数多く存在します。例えば、AI Fairness360は、AIモデルの公平性を評価するためのオープンソースツールキットです。Adversarial RobustnessToolboxは、AIモデルに対する敵対的攻撃への耐性を評価するためのツールキットです。SHAPは、AIモデルの予測に対する各特徴量の寄与度を説明するためのライブラリです。これらのツールは、AIシステムの様々な側面を検証するために活用できます。また、AIシステムの開発環境や運用環境に合わせて、適切なツールを選択することが重要です。例えば、クラウド環境でAIシステムを開発する場合は、クラウドプロバイダーが提供するセキュリティツールを活用することも有効です。AIシステムの特性やリスクを考慮し、最適なツールを組み合わせることで、より効果的な安全性検証を実現できます。

AI安全性検証の具体的な進め方

リスクアセスメントの実施

AIシステムの安全性検証の最初のステップは、リスクアセスメントの実施です。リスクアセスメントとは、AIシステムが抱える潜在的なリスクを特定し、その影響度と発生可能性を評価するプロセスです。リスクを特定するためには、AIシステムの目的、機能、データ、環境などを詳細に分析する必要があります。例えば、AIシステムが誤った判断をした場合にどのような影響が生じるか、AIシステムが不正アクセスを受けた場合にどのような被害が発生するかなどを検討します。リスクの評価では、特定されたリスクの影響度と発生可能性を評価します。影響度は、リスクが現実化した場合の被害の大きさを表し、発生可能性は、リスクが現実化する確率を表します。リスクアセスメントの結果に基づき、優先的に対応すべきリスクを特定し、適切な対策を講じることが重要です。

検証計画の策定

リスクアセスメントの結果を踏まえ、具体的な検証計画を策定します。検証計画には、検証の目的、範囲、方法、スケジュール、責任者などを明確に記述します。検証の目的は、特定されたリスクをどの程度低減するかを明確にすることです。検証の範囲は、AIシステムのどの部分を検証するかを明確にすることです。検証の方法は、どのようなツールや技術を用いて検証するかを明確にすることです。検証のスケジュールは、いつまでに検証を完了するかを明確にすることです。責任者は、誰が検証を実施し、結果を評価するかを明確にすることです。検証計画は、関係者間で共有し、合意を得ることが重要です。また、検証計画は、AIシステムの開発状況やリスクの変化に合わせて、柔軟に見直す必要があります。

検証の実施と結果の分析

検証計画に従い、実際に検証を実施します。検証では、様々なツールや技術を用いて、AIシステムの安全性、信頼性、倫理性を評価します。例えば、ファジングツールを用いて、AIシステムの脆弱性を検証したり、統計的な手法を用いて、AIシステムのバイアスを評価したりします。検証結果は、詳細に記録し、分析します。分析では、検証結果からどのようなリスクが明らかになったか、どのような改善が必要かなどを検討します。分析結果に基づき、AIシステムの設計や実装を修正し、再度検証を実施します。このプロセスを繰り返すことで、AIシステムの安全性を向上させることができます。検証結果は、関係者間で共有し、改善策の実施状況を共有することが重要です。

AI安全性検証の導入事例

事例1:医療機器へのAI導入

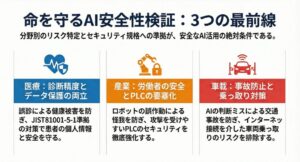

医療機器へのAI導入は、診断精度向上や業務効率化に貢献する一方で、患者の安全に関わる重大なリスクも伴います。例えば、AIが誤った診断を下した場合、患者の健康を損なう可能性があります。また、医療機器がサイバー攻撃を受けた場合、患者の個人情報が漏洩したり、医療機器が誤作動したりする可能性があります。そのため、医療機器へのAI導入においては、厳格な安全性検証が不可欠です。JIST81001-5-1は、医療機器のセキュリティに関する規格であり、AIを搭載した医療機器にも適用されます。この規格に準拠したセキュリティ対策を講じることで、サイバー攻撃のリスクを低減することができます。医療機器メーカーは、AIの安全性検証を徹底し、患者の安全を最優先に考慮する必要があります。

事例2:産業機器へのAI導入

産業機器へのAI導入は、生産性向上やコスト削減に貢献する一方で、労働者の安全や環境保護に関わるリスクも伴います。例えば、AIが制御するロボットが誤作動した場合、労働者が怪我をする可能性があります。また、AIが制御するプラントが異常停止した場合、環境汚染が発生する可能性があります。特に、PLC(プログラマブルロジックコントローラ)は、産業機器の制御に広く用いられていますが、セキュリティリスクが指摘されています。PLCがサイバー攻撃を受けた場合、産業機器が誤作動したり、停止したりする可能性があります。そのため、産業機器へのAI導入においては、PLCのセキュリティ対策を徹底し、AIシステムの安全性を検証する必要があります。

事例3:車載機器へのAI導入

車載機器へのAI導入は、運転支援や自動運転機能の高度化に貢献する一方で、人命に関わる重大なリスクも伴います。例えば、AIが誤った判断をした場合、交通事故を引き起こす可能性があります。また、車載機器がサイバー攻撃を受けた場合、車両が乗っ取られたり、誤作動したりする可能性があります。特に、カーナビゲーションやテレマティクスシステムは、インターネットに接続されているため、サイバー攻撃のリスクが高くなっています。そのため、車載機器へのAI導入においては、セキュリティ対策を徹底し、AIシステムの安全性を検証する必要があります。自動車メーカーは、AIの安全性検証を徹底し、交通事故の防止に努める必要があります。

まとめ:AI安全性検証の重要性と今後の展望

AI技術は、社会の様々な分野で活用され始めており、その可能性は計り知れません。しかし、AI技術の発展と普及に伴い、安全性に関する懸念も高まっています。AIシステムが予期せぬ動作をしたり、悪意のある攻撃を受けたりした場合、人命や財産に深刻な損害を与える可能性があります。そのため、AI安全性検証は、AI技術の発展と社会実装を両立させる上で、極めて重要な課題です。今後は、AI安全に関する国際標準規格の策定や、AI安全性検証技術の開発がますます進むと考えられます。また、AI開発者や利用者は、AI安全に関する知識を深め、安全性検証を徹底する必要があります。AI技術の恩恵を最大限に享受するためには、AI安全性検証の重要性を認識し、積極的に取り組むことが不可欠です。AIの安全性確保は社会全体の責任であり、産官学が連携して取り組むべき課題です。